J’ai eu le plaisir d’ouvrir la journée IA en Nouvelle Aquitaine, organisée par l’IA en Nouvelle Aquitaine. Pour cela, je me suis laissé aller sur des terrains parfois proche de la philosophie (probablement des résidus de la conférence Philosophia et de la Convention citoyenne). Ainsi, j’ai voulu répondre à une question qu’on ne me pose jamais mais qui est peut-être la raison pour laquelle l’IA a tellement besoin de confiance et d’explicabilité.

l’IA relève-t-elle encore du numérique ?

Evidemment, la question est provocatrice. Bien entendu l’IA fait partie du numérique mais ce que je voulais mettre en avant, c’est pourquoi ressent-on aujourd’hui le besoin si présent de confiance et d’explicabilité envers l’intelligence artificielle ? Pourquoi ne pas simplement utiliser nos vieilles recettes (on sait avoir confiance dans le numérique, on fait ça depuis des décennies). En suivant cette question assez simple, j’ai essayé de pointer du doigt ce qui change fondamentalement avec l’arrivée de l’IA générative, notamment dans notre rapport au sens, à la vérité, à la décision, et à la responsabilité.

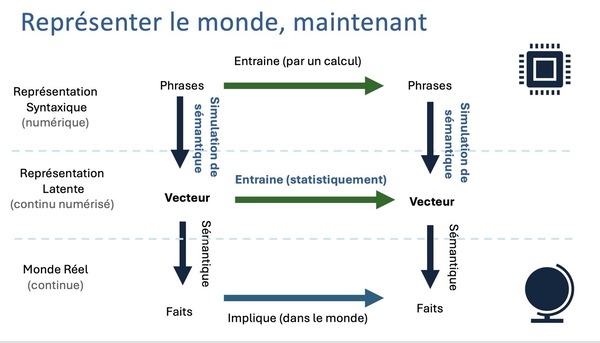

En deux mots, l’IA a bénéficié de l’explosion impressionnante du numérique, sa puissance et son omniprésence, dans notre quotidien. Elle en représente maintenant le point d’entrée mais cela va plus loin. L’IA générative change la donne. Le numérique était jusqu’à présent un moyen “documentaire” pour mieux appréhender le monde réel, l’analyser, le refléter. Mais, marquée par une progression continue des capacités de calcul, de stockage et de connectivité, l’IA générative a franchi un seuil : la machine ne se contente plus de manipuler des symboles, elle simule son propre sens (en quelques sortes), et celui-ci nous est étranger. Notre problème n’est plus de faire correspondre des symboles que la machine manipule vers notre réalité, mais de faire correspondre un sens qui nous est étranger (la représentation interne des IA) au sens que nous y mettons. Cela rend la tâche bien plus difficile !

Jusqu’à présent, en effet, on pouvait dormir paisiblement grâce à ce qui est appelé la double coupure numérique : d’un côté, une coupure sémantique, car la machine traite les signes sans en comprendre le sens réel — c’est toujours l’humain qui interprète ; de l’autre, une coupure matérielle, car le calcul est indépendant de la réalité physique. Nos méthodes de vérification et d’explication étaient basées sur une représentation (symbolique) formelle du monde et nous “n’avions qu’à” s’assurer de l’adéquation entre les symboles produits et leur réalité, leur sémantique (c’était déjà très complexe). Aujourd’hui, cette frontière entre syntaxe (symboles pour le calcul) et sémantique me semble plus fragile, du fait de l’utilisation par les LLM de points dans des espaces latents gigantesques, qui sont bien porteurs de sémantique (mais c’est un débat philosophique à lui tout seul).

Nos relations avec le numérique doivent changer avec l’IA. Les vieilles recettes que l’on avait développées avec le numérique n’y sont pas adaptées. Ce n’est plus un simple outil : c’est un acteur dans la production de savoirs, de sens, d’expériences émotionnelles. L’IA a transformé le numérique. Celui-ci n’est plus seulement documentaire.

Tout cela pour, en conclusion, chercher à comprendre pourquoi c’est extrêmement difficile de chercher à comprendre les grands modèles de langage. Est-ce seulement possible ?